国芯科技DPNPU新IP产品最新进展,单核支持0.5~4.8TOPS灵活算力配置

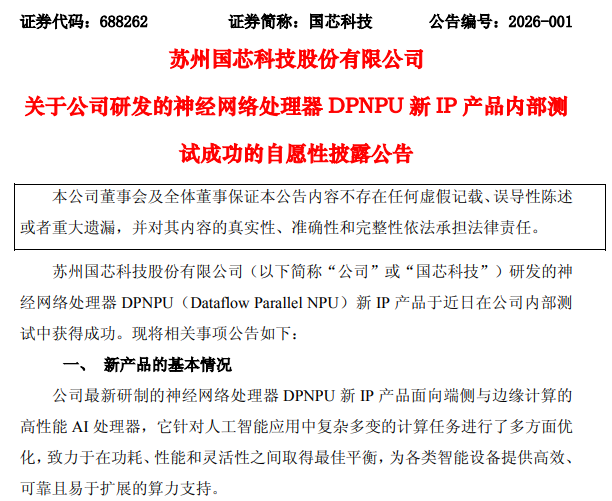

电子发烧友网综合报道 国芯科技发布公告称,其自主研发的 神经网络 处理器DPNPU(Dataflow Parallel NPU)新IP产品,在公司内部测试中取得了圆满成功。

国芯科技表示,公司最新推出的这款神经网络处理器DPNPU新IP产品,专为端侧与边缘计算设计,是一款高性能的 AI处理器。它针对 人工智能应用中复杂多变的计算任务,进行了多方面的优化,力求在功耗、性能和灵活性之间达到最佳平衡,从而为各类智能设备提供高效、可靠且易于扩展的算力支持。

国芯科技的DPNPU单核具备0.5~4.8 TOPS的灵活算力配置能力,并支持算力的线性扩展,能够根据不同场景的需求,提供定制化的AI算力解决方案。

在架构设计上,国芯科技的DPNPU采用了符合 RISC-V指令集架构( RISC-V ISA)标准的创新开放架构。该架构通过将RISC-V核心与高性能神经网络加速单元在架构层面进行深度融合与优化,并设计了专用的TDS(Task Distribu tion&Synchronization)硬件调度引擎作为核心控制单元,将网络模型中的算子序列转化为高效的节点化任务流,实现了任务管理、数据流控制与AI专用计算的统一高效调度。此外,该新IP产品还采用了脉动阵列高效动态融合技术,确保了设备在长时间运行中的稳定性和卓越能效表现。

DPNPU内置了90多种神经网络算子,全面覆盖了CNN、RNN等神经网络架构,并支持LSTM、GRU等RNN变体。通过RISC-V指令和硬件通用性设计,该产品可扩展支持更多算子,为适配未来不断涌现的AI模型预留了充足的空间。同时,DPNPU还支持训练后量化(PTQ)技术,提供了对称量化、非对称量化、逐层量化和逐通道量化四种方式,并支持INT8和FP16混合精度量化。在保持模型精度的前提下,该新IP产品大幅减少了计算资源和存储空间的占用,实现了精度与性能的完美平衡。

此外,DPNPU还集成了公司自研的PCD(Pa rameter Compression&Decompression)模块,支持参数压缩与硬件自动解压缩技术,有效缓解了数据吞吐瓶颈,降低了带宽压力,进一步提升了整体系统性能。

为了降低AI应用开发的门槛,国芯科技围绕自研的DPNPU构建了一套完整的软件生态——CCore NPU Studio。该生态集成了完整易用的工具套件、驱动和运行时软件,缩短了从开发到部署的周期,提升了AI应用的落地效率。其中,CCore NPU Studio工具套件为DPNPU提供了端到端的模型部署能力,包括模型转换、预处理、量化、编译、 仿真等工具软件;CCore NPU Runtime则提供了DPNPU运行时推理支撑,涵盖了推理框架软件和各种扩展软算子库;CCore NPU Driver则适配了RISC-V等主流 CPU平台,支持 Linux/ RTOS/Bare-metal等不同应用环境需求。

随着人工智能技术的加速渗透, 工业控制、智能家电、 汽车电子、医疗健康等关键领域对AI芯片的需求日益增长。与云端AI相比,端侧与边缘侧AI具备实时响应、数据隐私保护、低网络依赖等显著优势,这对芯片的能效比和算力密度提出了更高要求。国芯科技的DPNPU在架构可行性、能效表现及软件栈方面均已完成验证,为后续公司NPU技术的持续研发以及端侧和边缘侧AI芯片的发展和应用奠定了坚实基础。

国芯科技表示,公司对上述DPNPU新IP产品拥有完整的知识产权。本次神经网络处理器DPNPU新IP产品的研发成功,是公司在人工智能领域长期坚持创新驱动的结果,预计将对公司未来的市场拓展和业绩成长性产生积极影响。

- 随机文章

- 热门文章

- 热评文章

- 河南粮食重点领域贷款余额超2595亿元,河南粮食重点领域贷款余额超2595亿元

- 求职遇到“招转贷”怎么办?人社部回应,求职遇到“招转贷”怎么办?人社部回应

- 从世俱杯到家庭厨房,海信真空冰箱用“MVP OF FRESHNESS”抢占保鲜C位,从世俱杯到家庭厨房,海信真空冰箱用“MVP OF FRESHNESS”抢占保鲜C位

- 中企承建的非洲最长矮塔斜拉桥建成通车,中企承建的非洲最长矮塔斜拉桥建成通车

- 珠江啤酒(002461):公司董事长辞职及选举董事长

- 国联股份(603613):使用自有资金支付募投项目部分款项并以募集资金等额置换

- 芯朋微(688508):德恒上海律师事务所关于无锡芯朋微电子股份有限公司2025年第一次临时股东大会之见证意见

- 莱美药业(300006):持股5%以上股东所持部分股份被动减持的预披露公告

- 1[风险]嘉实原油LOF (160723): 嘉实原油证券投资基金(QDII-LOF)溢价风险提示公告

- 2广西三地接连发布公告:禁止前往!后果自负!

- 3甜蜜的事业,幸福的滋味……

- 4SCADA系统的NAT转换与网段隔离解决方案

- 5芦苇任中国邮政集团副总经理

- 6A股三大股指集体收涨,沪指续创10年新高,A股三大股指集体收涨,沪指续创10年新高

- 7穆勒矩阵椭偏仪:DVRMME技术的系统误差建模与校准补偿

- 8政策定调催生新主线,A股跨年行情蓄势待发

- 1废砖瓦里砌出风景线 湖南靖州深山村寨美丽嬗变,废砖瓦里砌出风景线 湖南靖州深山村寨美丽嬗变

- 2文科生也可以学医了!多所高校中医学类专业选科放宽,文科生也可以学医了!多所高校中医学类专业选科放宽

- 3湖南零陵发展数字农业 现代农民种粮更轻松,湖南零陵发展数字农业 现代农民种粮更轻松

- 4上午买食材、下午逛潮店 古城老菜场人气足,上午买食材、下午逛潮店 古城老菜场人气足

- 5广东怀集所有国省道主线均已抢通,广东怀集所有国省道主线均已抢通

- 6520分钟攻坚!成渝中线高铁成都站改建工程进度过半,520分钟攻坚!成渝中线高铁成都站改建工程进度过半

- 7广东清远连山紧急转移8名村民 避险山体滑坡,广东清远连山紧急转移8名村民 避险山体滑坡

- 8中意经典著作互译出版项目启动 四部重磅作品首批入选,中意经典著作互译出版项目启动 四部重磅作品首批入选